Поисковик Ucoz

Robots.txt - это текстовый файл в корне сайта со специальными инструкциями для поисковых роботов. В нем вы можете указать поисковикам как индексировать ваш сайт.

Robots.txt - это текстовый файл в корне сайта со специальными инструкциями для поисковых роботов. В нем вы можете указать поисковикам как индексировать ваш сайт.

По-умолчанию системой подгружается "стандартная заглушка", в которую добавлено большинство "правильных" команд, но все же их бывает не достаточно.

Напоминаю, что новый сайт на юкозе первый месяц находится на т.н. "карантине", то-бишь он запрещен к индексации. Это испытательный период, который дается вашему сайту, чтобы доказать свою "серьезность". За это время вам стоит продумать структуру сайта, наполнить его уникальным контентом, подчистить шаблон, обзавестись социальными аккаунтами и т.д. После 30-ти дней испытательного срока карантин будет снят и вы получите свободный доступ к robots.txt

Стоит также отметить что карантин будет снят немедленно если вы закажете любую доп. услугу на сумму >$2.

Теперь ближе к делу...

Вот так выглядит стандартный файл robots.txt от uCoz:

Код

User-agent: *Allow: /*?page

Allow: /*?ref=

Disallow: /*?

Disallow: /stat/

Disallow: /index/1

Disallow: /index/3

Disallow: /register

Disallow: /index/5

Disallow: /index/7

Disallow: /index/8

Disallow: /index/9

Disallow: /index/sub/

Disallow: /panel/

Disallow: /admin/

Disallow: /informer/

Disallow: /secure/

Disallow: /poll/

Disallow: /search/

Disallow: /abnl/

Disallow: /*_escaped_fragment_=

Disallow: /*-*-*-*-987$

Disallow: /shop/checkout/

Disallow: /shop/user/

Disallow: /*0-*-0-17$

Disallow: /*0-0-

Sitemap:

Если вы хотите внести какие-то правки - вам необходимо создать текстовый файл robots.txt в корне своего сайта и уже в него вносить изменения. В этом случае системой будет отдаваться ваш кастумный robots.txt

В принципе базовый файл настроен правильно - все лишнее от индексирования закрыто. Но как говорится нет предела совершенству и поэтому я немного изменил его содержание "под себя".

Не так давно я уже писал заметку о дублях SSID для главной страницы - поэтому у меня уже есть правило, которое убирает с индекса эти "ляпы" системы.

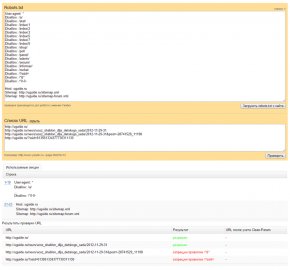

Но недавно появились новые "дубли":

Поисковые системы очень негативно относятся к наличию дублированного контента в индексе. Поэтому подобные урлы нужно закрыть. Устранить саму причину появления невозможно, так что будем бороться с последствиями. В данном случае строкой:

Теперь файл robots.txt для моего сайта настроен правильно и должен устранить "ляпы" системы (которые проявили себя на данный момент на модуле Блог).

После всех изменений рекомендую проверить корректность составленного robots в панеле Яндекс.Вебмастер - .